Trong thế giới tối ưu hóa công cụ tìm kiếm (SEO), việc Google thu thập dữ liệu từ website là yếu tố sống còn để đảm bảo nội dung được hiển thị đúng và kịp thời trên trang kết quả tìm kiếm. Tuy nhiên, không ít người vẫn nhầm lẫn giữa khái niệm “crawl”, “index” và “rank”. Vậy crawl dữ liệu website là gì, và nó đóng vai trò gì trong quá trình Google đưa nội dung của bạn lên top tìm kiếm?

Định nghĩa crawl dữ liệu website là gì?

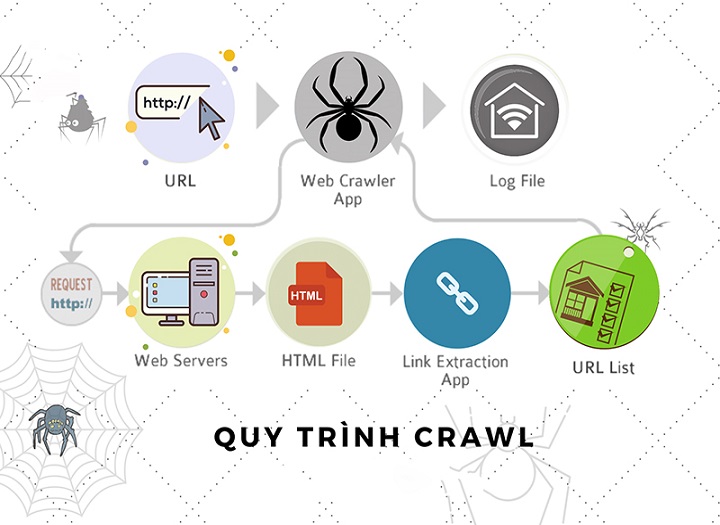

Crawl dữ liệu website là quá trình trong đó các công cụ tìm kiếm – điển hình là Googlebot – sử dụng các chương trình tự động (còn gọi là “web crawler” hoặc “bot”) để truy cập và thu thập thông tin từ các trang web trên Internet. Dữ liệu được crawl sẽ được xử lý, đánh giá và lưu trữ vào chỉ mục tìm kiếm (index) để phục vụ việc truy xuất thông tin khi người dùng tìm kiếm.

Mở rộng định nghĩa và vai trò trong hệ thống tìm kiếm

Về bản chất, crawl dữ liệu là bước đầu tiên trong quy trình 3 bước cốt lõi của máy tìm kiếm: Crawl → Index → Rank. Nếu trang web không được crawl, đồng nghĩa với việc nội dung sẽ không bao giờ xuất hiện trên Google. Hoạt động crawl diễn ra liên tục, có thể theo chu kỳ nhất định hoặc ngay lập tức tùy theo độ uy tín và độ cập nhật của website. Ngoài ra, các yếu tố như robots.txt, sitemap.xml và tốc độ phản hồi máy chủ cũng ảnh hưởng đến khả năng crawl.

Khi đã hiểu crawl dữ liệu website là gì, nhiều người thắc mắc Googlebot thực hiện crawl như thế nào? Quá trình này không phải ngẫu nhiên mà tuân theo nguyên lý kỹ thuật chặt chẽ, gồm các thành phần như trình thu thập, hệ thống chỉ mục, và cấu hình website.

Web crawler (hoặc “bot”) là thành phần chính chịu trách nhiệm “bò” qua các trang web. Google sử dụng một phiên bản nâng cao gọi là Googlebot. Bot sẽ truy cập URL bắt đầu từ các liên kết đã biết, rồi lần lượt theo các liên kết trên trang để tìm thêm trang mới. Quá trình này được gọi là crawling – nghĩa là “bò qua” và thu thập dữ liệu HTML, hình ảnh, metadata,…

Googlebot sử dụng cơ chế gọi là scheduled crawling – nghĩa là nó ưu tiên crawl các trang được cập nhật thường xuyên hoặc có độ uy tín cao. Cơ chế crawl còn phụ thuộc vào:

Googlebot thu thập nội dung, chuyển tới bộ xử lý trung tâm để đánh giá và quyết định index.

Quy trình chuẩn gồm 4 bước:

Trang web được crawl càng đầy đủ, cơ hội hiển thị trên Google càng cao.

Cấu hình trong robots.txt có thể chặn toàn bộ hoặc một phần website khỏi bị crawl, ví dụ:

User-agent: *

Disallow: /private/

Ngược lại, sitemap.xml giúp bot biết chính xác các URL cần ưu tiên crawl, đặc biệt quan trọng với site có hàng nghìn trang.

Khi tìm hiểu crawl dữ liệu website là gì, người dùng thường bất ngờ khi biết rằng quá trình này không chỉ có một hình thức duy nhất. Thực tế, Googlebot và các công cụ khác có thể thực hiện nhiều dạng crawl khác nhau, tùy theo mục tiêu và cách thức thu thập dữ liệu.

Đây là dạng crawl toàn bộ nội dung của website, từ trang chủ đến từng trang con. Hình thức này thường áp dụng khi:

Đặc điểm:

Googlebot thường lên lịch crawl theo chu kỳ để cập nhật nội dung mới. Tần suất phụ thuộc vào:

Khi người quản trị web sử dụng công cụ như Google Search Console để yêu cầu crawl lại một URL cụ thể, Googlebot sẽ thực hiện crawl theo yêu cầu. Hữu ích khi:

Googlebot có thể thực hiện crawl riêng biệt cho:

Điều này cho phép thu thập dữ liệu chuyên sâu theo từng định dạng nội dung.

Nhiều người cho rằng chỉ cần Google crawl là nội dung đã hiển thị trên kết quả tìm kiếm. Thực tế không đơn giản như vậy. Crawl và index là hai giai đoạn hoàn toàn khác nhau và có vai trò riêng biệt trong quá trình hiển thị nội dung.

|

Yếu tố |

Crawl dữ liệu website |

Index website |

|---|---|---|

|

Định nghĩa |

Quá trình bot truy cập, thu thập nội dung trang |

Quá trình lưu trữ nội dung đã crawl vào chỉ mục |

|

Công cụ thực hiện |

Web crawler (Googlebot) |

Hệ thống xử lý dữ liệu của Google |

|

Thời điểm diễn ra |

Trước khi index |

Sau khi crawl |

|

Điều kiện xảy ra |

Phụ thuộc vào robots.txt, sitemap, server… |

Phụ thuộc chất lượng nội dung, cấu trúc trang |

|

Ảnh hưởng tới SEO |

Không crawl = không index |

Không index = không hiển thị trên Google |

Hãy tưởng tượng một website có hàng ngàn trang sản phẩm, bài viết blog, hoặc tin tức nhưng không một trang nào hiển thị trên Google. Vấn đề không nằm ở nội dung, mà nằm ở việc các trang đó chưa được crawl. Vậy crawl dữ liệu website có giá trị thực tiễn như thế nào đối với người làm web, SEO và người dùng cuối?

Không ít quản trị viên và người học SEO mắc sai lầm khiến website không được crawl hoặc crawl kém hiệu quả. Dưới đây là những hiểu nhầm phổ biến và cảnh báo cần biết khi tìm hiểu crawl dữ liệu website là gì.

Một website có thể sở hữu nội dung chất lượng, giao diện thân thiện nhưng vẫn “vô hình” trên Google nếu khả năng crawl của Googlebot bị hạn chế. Vậy làm sao để tối ưu việc crawl dữ liệu và đảm bảo mọi trang quan trọng được Google thu thập kịp thời?

User-agent: *

Disallow: /cart/

Disallow: /search/

Hiểu đúng crawl dữ liệu website là gì là bước khởi đầu quan trọng để tối ưu SEO hiệu quả. Từ việc cấu hình robots.txt, sitemap đến tối ưu tốc độ trang, mọi yếu tố đều ảnh hưởng tới khả năng crawl. Quản trị viên website cần nắm chắc cơ chế crawl để đảm bảo nội dung luôn được cập nhật và hiện diện trên công cụ tìm kiếm. Đây cũng là nền tảng để bước tiếp sang tối ưu index và xếp hạng.

Bạn có thể kiểm tra qua Google Search Console > “Báo cáo crawl”, hoặc tìm URL trên Google bằng lệnh site:domain.com.

Không, Googlebot không thể truy cập trang cần đăng nhập hoặc bị bảo vệ bởi mật khẩu.

Có, phổ biến nhất là Screaming Frog, Ahrefs, SEMrush, và Google Search Console.

Có, nhưng tốc độ và phạm vi crawl bị hạn chế. Sitemap giúp bot phát hiện nhanh URL mới và quan trọng.

Có thể. Sử dụng công cụ “URL Inspection” trong Google Search Console để gửi yêu cầu crawl lại.